#!/usr/bin/env python

# coding: utf-8

# # Probabilidad y Estadística con Python

# *Esta notebook fue creada originalmente como un blog post por [Raúl E. López Briega](http://relopezbriega.com.ar/) en [Mi blog sobre Python](http://relopezbriega.github.io). El contenido esta bajo la licencia BSD.*

#  # Actualmente con el boom de la [Big Data](http://es.wikipedia.org/wiki/Big_data), tener nociones de *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)* y *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* se ha hecho fundamental. En los últimos años ha habido un resurgimiento de todo lo relacionado con *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* , *[data mining](http://es.wikipedia.org/wiki/Miner%C3%ADa_de_datos)* y *[machine learning](http://es.wikipedia.org/wiki/Aprendizaje_autom%C3%A1tico)* empujados principalmente por la explosión de datos con que contamos, estos conceptos combinados forman la base de lo que actualmente se conoce como la *[Ciencia de Datos](http://en.wikipedia.org/wiki/Data_science)*. Dentro de este contexto, [Python](http://python.org/) es uno de los lenguajes que más nos facilita trabajar con datos. Realizar complejos análisis estadísticos nunca fue tan fácil como con [Python](http://python.org/)!

#

# ## ¿Qué es la Estadística?

#

# La *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* suele ser definida como la ciencia de aprender de los *[datos](https://es.wikipedia.org/wiki/Dato)* o como la ciencia de obtener conclusiones en la presencia de incertidumbre. Se relaciona principalmente con la recolección, análisis e interpretación de *[datos](https://es.wikipedia.org/wiki/Dato)*, así como también con la efectiva comunicación y presentación de los resultados basados en esos *[datos](https://es.wikipedia.org/wiki/Dato)*. Como por *[datos](https://es.wikipedia.org/wiki/Dato)* entendemos a cualquier clase de información grabada, la *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* juego un rol importante en muchas disciplinas científicas.

#

# La *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* puede ser muy importante para una efectiva toma de decisiones. Existe una gran cantidad de valiosa información escondida entre los *[datos](https://es.wikipedia.org/wiki/Dato)*, pero esta información no suele ser fácilmente accesible, la *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* nos brinda los principios fundamentales que nos permiten extraer y entender esa información; tambien nos proporciona las herramientas necesarias para verificar la calidad de nuestros *[datos](https://es.wikipedia.org/wiki/Dato)* y nuestra información.

#

# La *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* suele ser dividida en dos grandes ramas:

#

# 1. La *[estadística descriptiva](https://es.wikipedia.org/wiki/Estad%C3%ADstica_descriptiva)*: La cual se dedica a recolectar, ordenar, analizar y representar a un [conjunto de datos](https://es.wikipedia.org/wiki/Conjunto_de_datos), con el fin de describir apropiadamente las características de este. Calcula los parámetros estadísticos que describen el conjunto estudiado. Algunas de las herramientas que utiliza son gráficos, medidas de frecuencias, medidas de centralización, medidas de posición, medidas de dispersión, entre otras.

#

# 2. La *[estadistica inferencial](https://es.wikipedia.org/wiki/Estad%C3%ADstica_inferencial)*: La cual estudia cómo sacar conclusiones generales para toda la [población](https://es.wikipedia.org/wiki/Poblaci%C3%B3n_estad%C3%ADstica) a partir del estudio de una muestra, y el grado de fiabilidad o significación de los resultados obtenidos. Sus principales herramientas son el muestreo, la estimación de parámetros y el contraste de hipótesis.

# ## ¿Qué es la Probabilidad?

#

# La *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)* mide la mayor o menor posibilidad de que se dé un determinado resultado (suceso o evento) cuando se realiza un experimento aleatorio.

# Para calcular la probabilidad de un evento se toma en cuenta todos los casos posibles de ocurrencia del mismo; es decir, de cuántas formas puede ocurrir determinada situación.Los casos favorables de ocurrencia de un evento serán los que cumplan con la condición que estamos buscando. La *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)* toma valores entre 0 y 1 (o expresados en tanto por ciento, entre 0% y 100%).

#

# La *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)* es a la vez el inverso y complemento para la *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)*. Dónde la *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* nos ayuda a ir desde los *[datos](https://es.wikipedia.org/wiki/Dato)* observados hasta hacer generalizaciones sobre como funcionan las cosas; la *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)* funciona en la dirección inversa: si asumimos que sabemos como las cosas funcionan, entonces podemos averiguar la clase de *[datos](https://es.wikipedia.org/wiki/Dato)* que vamos a ver y cuan probable es que los veamos.

#

# La *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)* también funciona como complemento de la *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* cuando nos proporciona una sólida base para la *[estadistica inferencial](https://es.wikipedia.org/wiki/Estad%C3%ADstica_inferencial)*. Cuando hay incertidumbre, no sabemos que puede pasar y hay alguna posibilidad de errores, utilizando *[probabilidades](https://es.wikipedia.org/wiki/Probabilidad)* podemos aprender formas de controlar la tasa de errores para reducirlos.

# ## Actividades básicas del analisis estadístico

#

# Las técnicas *[estadísticas](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* deberían ser vistas como una parte importante de cualquier proceso de toma de dicisiones, permitiendo tomar decisiones estratégicamente informadas que combinen intuición con experiencia y un entendimiento *[estadístico](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* de los *[datos](https://es.wikipedia.org/wiki/Dato)* que tenemos disponibles.

#

# Un análisis estadístico suele contener 5 actividades básicas:

#

# 1. **Diseño del análisis**: Esta actividad involucra el planeamiento de los detalles para obtener los datos que necesitamos y la generación de la hipótesis a ser evaluada.

#

# 2. **Exploración de datos**: En esta actividad nos dedicamos a jugar con nuestros datos, los describimos, los resumimos, realizamos gráficos para mirarlos desde distintos ángulos. Esta exploración nos ayuda a asegurarnos que los datos que obtuvimos son completos y que la etapa de diseño fue correcta.

#

# 3. **Armado del modelo**: En esta actividad intentamos armar un modelo que explique el comportamiento de nuestros datos y pueda llegar a hacer predicciones sobre los mismos. La idea es que el modelo pueda describir las propiedades fundamentales de nuestros datos.

#

# 4. **Realizar estimaciones**: Aquí vamos a intentar realizar estimaciones basadas en el modelo que armamos anteriormente. También vamos a intentar estimar el tamaño del error que nuestro modelo puede tener en sus predicciones.

#

# 5. **Contraste de la hipótesis**: Esta actividad es la que va a producir la decisión final sobre si las predicciones del modelo son correctas y ayudarnos a concluir si los datos que poseemos confirman o rechazan la hipótesis que generamos en la actividad 1.

# ## Conceptos básicos de la estadística descriptiva

#

# En *[estadística descriptiva](https://es.wikipedia.org/wiki/Estad%C3%ADstica_descriptiva)* se utilizan distintas medidas para intentar describir las propiedades de nuestros datos, algunos de los conceptos básicos, son:

#

# * **Media aritmética**: La [media aritmética](https://es.wikipedia.org/wiki/Media_aritm%C3%A9tica) es el valor obtenido al sumar todos los *[datos](https://es.wikipedia.org/wiki/Dato)* y dividir el resultado entre el número total elementos. Se suele representar con la letra griega $\mu$. Si tenemos una [muestra](https://es.wikipedia.org/wiki/Muestra_estad%C3%ADstica) de $n$ valores, $x_i$, la *media aritmética*, $\mu$, es la suma de los valores divididos por el numero de elementos; en otras palabras:

# $$\mu = \frac{1}{n} \sum_{i}x_i$$

#

#

# * **Desviación respecto a la media**: La desviación respecto a la media es la diferencia en valor absoluto entre cada valor de la variable estadística y la media aritmética.

# $$D_i = |x_i - \mu|$$

#

#

# * **Varianza**: La [varianza](https://es.wikipedia.org/wiki/Varianza) es la media aritmética del cuadrado de las desviaciones respecto a la media de una distribución estadística. La varianza intenta describir la dispersión de los *[datos](https://es.wikipedia.org/wiki/Dato)*. Se representa como $\sigma^2$.

# $$\sigma^2 = \frac{\sum\limits_{i=1}^n(x_i - \mu)^2}{n} $$

#

#

# * **Desviación típica**: La [desviación típica](https://es.wikipedia.org/wiki/Desviaci%C3%B3n_t%C3%ADpica) es la raíz cuadrada de la varianza. Se representa con la letra griega $\sigma$.

# $$\sigma = \sqrt{\frac{\sum\limits_{i=1}^n(x_i - \mu)^2}{n}} $$

#

#

# * **Moda**: La moda es el valor que tiene mayor frecuencia absoluta. Se representa con $M_0$

#

#

# * **Mediana**: La mediana es el valor que ocupa el lugar central de todos los datos cuando éstos están ordenados de menor a mayor. Se representa con $\widetilde{x}$.

#

#

# * **Correlación**: La [correlación](https://es.wikipedia.org/wiki/Correlaci%C3%B3n) trata de establecer la relación o dependencia que existe entre las dos variables que intervienen en una distribución bidimensional. Es decir, determinar si los cambios en una de las variables influyen en los cambios de la otra. En caso de que suceda, diremos que las variables están correlacionadas o que hay correlación entre ellas. La correlación es positiva cuando los valores de las variables aumenta juntos; y es negativa cuando un valor de una variable se reduce cuando el valor de la otra variable aumenta.

#

#

# * **Covarianza**: La [covarianza](https://es.wikipedia.org/wiki/Covarianza) es el equivalente de la varianza aplicado a una variable bidimensional. Es la media aritmética de los productos de las desviaciones de cada una de las variables respecto a sus medias respectivas.La covarianza indica el sentido de la correlación entre las variables; Si $\sigma_{xy} > 0$ la correlación es directa; Si $\sigma_{xy} < 0$ la correlación es inversa.

#

# $$\sigma_{xy} = \frac{\sum\limits_{i=1}^n(x_i - \mu_x)(y_i -\mu_y)}{n}$$

#

#

# * **Valor atípico**: Un [valor atípico](https://es.wikipedia.org/wiki/Valor_at%C3%ADpico) es una observación que se aleja demasiado de la moda; esta muy lejos de la tendencia principal del resto de los *[datos](https://es.wikipedia.org/wiki/Dato)*. Pueden ser causados por errores en la recolección de *[datos](https://es.wikipedia.org/wiki/Dato)* o medidas inusuales. Generalmente se recomienda eliminarlos del [conjunto de datos](https://es.wikipedia.org/wiki/Conjunto_de_datos).

#

# ## Librerías de Python para probabilidad y estadística

#

# Como ya les vengo mostrando en mis anteriores artículos, [Python](http://python.org/) se lleva muy bien con las matemáticas. Además, la [comunidad python](https://www.python.org/community/) es tan amplia que solemos encontrar una librería para cualquier problema al que nos enfrentemos. En este caso, los principales módulos que [Python](http://python.org/) nos ofrece para trabajar con *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)* y *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)*, son:

#

# * **[numpy](http://www.numpy.org/)**: El popular paquete matemático de [Python](http://python.org/), se utiliza tanto que mucha gente ya lo considera parte integral del lenguaje. Nos proporciona algunas funciones estadísticas que podemos aplicar fácilmente sobre los *arrays* de [Numpy](http://www.numpy.org/).

#

# * **[scipy.stats](http://docs.scipy.org/doc/scipy/reference/tutorial/stats.html)**: Este submodulo del paquete científico [Scipy](http://docs.scipy.org/doc/scipy/reference/index.html) es el complemento perfecto para [Numpy](http://www.numpy.org/), las funciones estadisticas que no encontremos en uno, las podemos encontrar en el otro.

#

# * **[statsmodels](http://statsmodels.sourceforge.net/)**: Esta librería nos brinda un gran número de herramientas para explorar *[datos](https://es.wikipedia.org/wiki/Dato)*, estimar modelos estadísticos, realizar pruebas estadísticas y muchas cosas más.

#

# * **[matplotlib](http://matplotlib.org/)**: Es la librería más popular en [Python](http://python.org/) para visualizaciones y gráficos. Ella nos va a permitir realizar los gráficos de las distintas distribuciones de datos.

#

# * **[seaborn](http://stanford.edu/~mwaskom/software/seaborn/)**: Esta librería es un complemento ideal de [matplotlib](http://matplotlib.org/) para realizar gráficos estadísticos.

#

# * **[pandas](http://pandas.pydata.org/)**: Esta es la librería más popular para análisis de *[datos](https://es.wikipedia.org/wiki/Dato)* y financieros. Posee algunas funciones muy útiles para realizar *[estadística descriptiva](https://es.wikipedia.org/wiki/Estad%C3%ADstica_descriptiva)* sobre nuestros datos y nos facilita sobremanera el trabajar con [series de tiempo](https://es.wikipedia.org/wiki/Serie_temporal).

#

# * **[pyMC](http://pymc-devs.github.io/pymc/index.html)**: [pyMC](http://pymc-devs.github.io/pymc/index.html) es un módulo de [Python](http://python.org/) que implementa modelos estadísticos bayesianos, incluyendo la [cadena de Markov Monte Carlo(MCMC)](https://en.wikipedia.org/wiki/Markov_chain_Monte_Carlo). [pyMC](http://pymc-devs.github.io/pymc/index.html) ofrece funcionalidades para hacer el análisis bayesiano lo mas simple posible.

# ### Ejemplos en Python

#

# Calcular los principales indicadores de la *[estadística descriptiva](https://es.wikipedia.org/wiki/Estad%C3%ADstica_descriptiva)* con [Python](http://python.org/) es muy fácil!.

# In[1]:

# Ejemplos de estadistica descriptiva con python

import numpy as np # importando numpy

from scipy import stats # importando scipy.stats

import pandas as pd # importando pandas

np.random.seed(2131982) # para poder replicar el random

# In[2]:

datos = np.random.randn(5, 4) # datos normalmente distribuidos

datos

# In[3]:

# media arítmetica

datos.mean() # Calcula la media aritmetica de

# In[4]:

np.mean(datos) # Mismo resultado desde la funcion de numpy

# In[5]:

datos.mean(axis=1) # media aritmetica de cada fila

# In[6]:

datos.mean(axis=0) # media aritmetica de cada columna

# In[7]:

# mediana

np.median(datos)

# In[8]:

np.median(datos, 0) # media aritmetica de cada columna

# In[9]:

# Desviación típica

np.std(datos)

# In[10]:

np.std(datos, 0) # Desviación típica de cada columna

# In[11]:

# varianza

np.var(datos)

# In[12]:

np.var(datos, 0) # varianza de cada columna

# In[13]:

# moda

stats.mode(datos) # Calcula la moda de cada columna

# el 2do array devuelve la frecuencia.

# In[14]:

datos2 = np.array([1, 2, 3, 6, 6, 1, 2, 4, 2, 2, 6, 6, 8, 10, 6])

stats.mode(datos2) # aqui la moda es el 6 porque aparece 5 veces en el vector.

# In[15]:

# correlacion

np.corrcoef(datos) # Crea matriz de correlación.

# In[16]:

# calculando la correlación entre dos vectores.

np.corrcoef(datos[0], datos[1])

# In[17]:

# covarianza

np.cov(datos) # calcula matriz de covarianza

# In[18]:

# covarianza de dos vectores

np.cov(datos[0], datos[1])

# In[19]:

# usando pandas

dataframe = pd.DataFrame(datos, index=['a', 'b', 'c', 'd', 'e'],

columns=['col1', 'col2', 'col3', 'col4'])

dataframe

# In[20]:

# resumen estadistadistico con pandas

dataframe.describe()

# In[21]:

# sumando las columnas

dataframe.sum()

# In[22]:

# sumando filas

dataframe.sum(axis=1)

# In[23]:

dataframe.cumsum() # acumulados

# In[24]:

# media aritmetica de cada columna con pandas

dataframe.mean()

# In[25]:

# media aritmetica de cada fila con pandas

dataframe.mean(axis=1)

# ## Histogramas y Distribuciones

#

# Muchas veces los indicadores de la *[estadística descriptiva](https://es.wikipedia.org/wiki/Estad%C3%ADstica_descriptiva)* no nos proporcionan una imagen clara de nuestros *[datos](https://es.wikipedia.org/wiki/Dato)*. Por esta razón, siempre es útil complementarlos con gráficos de las distribuciones de los *[datos](https://es.wikipedia.org/wiki/Dato)*, que describan con qué frecuencia aparece cada valor. La representación más común de una distribución es un [histograma](https://es.wikipedia.org/wiki/Histograma), que es un gráfico que muestra la frecuencia o probabilidad de cada valor. El [histograma](https://es.wikipedia.org/wiki/Histograma) muestra las frecuencias como un gráfico de barras que indica cuan frecuente un determinado valor ocurre en el [conjunto de datos](https://es.wikipedia.org/wiki/Conjunto_de_datos). El eje horizontal representa los valores del [conjunto de datos](https://es.wikipedia.org/wiki/Conjunto_de_datos) y el eje vertical representa la frecuencia con que esos valores ocurren.

#

# Las distribuciones se pueden clasificar en dos grandes grupos:

#

# 1. Las **[distribuciones continuas](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_de_probabilidad_continua)**, que son aquellas que presentan un número infinito de posibles soluciones. Dentro de este grupo vamos a encontrar a las distribuciones:

# * [normal](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_normal),

# * [gamma](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_gamma),

# * [chi cuadrado](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_%CF%87%C2%B2),

# * [t de Student](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_t_de_Student),

# * [pareto](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_de_Pareto),

# * entre otras

#

# 2. Las **distribuciones discretas**, que son aquellas en las que la variable puede pude tomar un número determinado de valores. Los principales exponenetes de este grupo son las distribuciones:

# * [poisson](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_de_Poisson),

# * [binomial](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_binomial),

# * [hipergeométrica](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_hipergeom%C3%A9trica),

# * [bernoulli](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_de_Bernoulli)

# * entre otras

#

# Veamos algunos ejemplos graficados con la ayuda de [Python](http://python.org/).

# ### Distribución normal

#

# La [distribución normal](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_normal) es una de las principales distribuciones, ya que es la que con más frecuencia aparece aproximada en los fenómenos reales. Tiene una forma acampanada y es simétrica respecto de un determinado parámetro estadístico. Con la ayuda de [Python](http://python.org/) la podemos graficar de la siguiente manera:

# In[26]:

# Graficos embebidos.

get_ipython().run_line_magic('matplotlib', 'inline')

# In[27]:

import matplotlib.pyplot as plt # importando matplotlib

import seaborn as sns # importando seaborn

# parametros esteticos de seaborn

sns.set_palette("deep", desat=.6)

sns.set_context(rc={"figure.figsize": (8, 4)})

# In[28]:

mu, sigma = 0, 0.1 # media y desvio estandar

s = np.random.normal(mu, sigma, 1000) #creando muestra de datos

# In[29]:

# histograma de distribución normal.

cuenta, cajas, ignorar = plt.hist(s, 30, normed=True)

normal = plt.plot(cajas, 1/(sigma * np.sqrt(2 * np.pi)) *

np.exp( - (cajas - mu)**2 / (2 * sigma**2) ),

linewidth=2, color='r')

# ### Distribuciones simetricas y asimetricas

#

# Una distribución es simétrica cuando moda, mediana y media coinciden aproximadamente en sus valores. Si una distribución es simétrica, existe el mismo número de valores a la derecha que a la izquierda de la media, por tanto, el mismo número de desviaciones con signo positivo que con signo negativo.

#

# Una distribución tiene [asimetria](https://es.wikipedia.org/wiki/Asimetr%C3%ADa_estad%C3%ADstica) positiva (o a la derecha) si la "cola" a la derecha de la media es más larga que la de la izquierda, es decir, si hay valores más separados de la media a la derecha. De la misma forma una distribución tiene [asimetria](https://es.wikipedia.org/wiki/Asimetr%C3%ADa_estad%C3%ADstica) negativa (o a la izquierda) si la "cola" a la izquierda de la media es más larga que la de la derecha, es decir, si hay valores más separados de la media a la izquierda.

#

# Las distribuciones asimétricas suelen ser problemáticas, ya que la mayoría de los métodos estadísticos suelen estar desarrollados para distribuciones del tipo [normal](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_normal). Para salvar estos problemas se suelen realizar transformaciones a los datos para hacer a estas distribuciones más simétricas y acercarse a la [distribución normal](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_normal).

# In[30]:

# Dibujando la distribucion Gamma

x = stats.gamma(3).rvs(5000)

gamma = plt.hist(x, 70, histtype="stepfilled", alpha=.7)

# En este ejemplo podemos ver que la [distribución gamma](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_gamma) que dibujamos tiene una [asimetria](https://es.wikipedia.org/wiki/Asimetr%C3%ADa_estad%C3%ADstica) positiva.

# In[31]:

# Calculando la simetria con scipy

stats.skew(x)

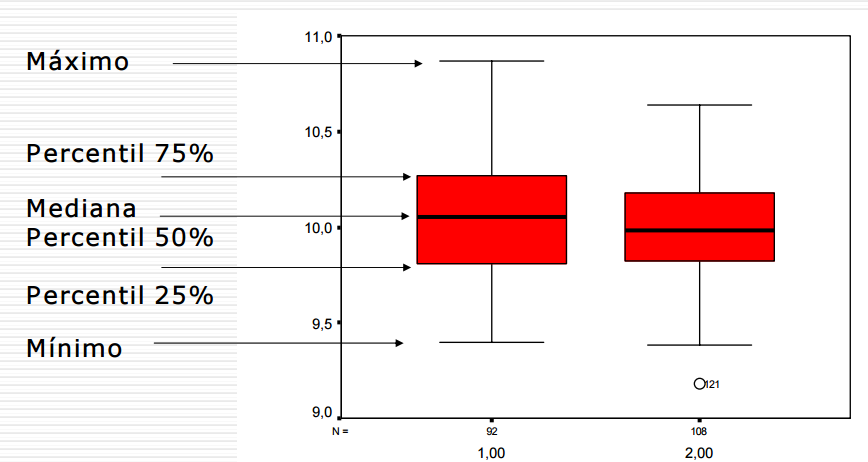

# ## Cuartiles y diagramas de cajas

#

# Los **[cuartiles](https://es.wikipedia.org/wiki/Cuartil)** son los tres valores de la variable estadística que dividen a un [conjunto de datos](https://es.wikipedia.org/wiki/Conjunto_de_datos) ordenados en cuatro partes iguales. Q1, Q2 y Q3 determinan los valores correspondientes al 25%, al 50% y al 75% de los datos. Q2 coincide con la mediana.

#

# Los [diagramas de cajas](https://es.wikipedia.org/wiki/Diagrama_de_caja) son una presentación visual que describe varias características importantes al mismo tiempo, tales como la dispersión y simetría. Para su realización se representan los tres cuartiles y los valores mínimo y máximo de los datos, sobre un rectángulo, alineado horizontal o verticalmente. Estos gráficos nos proporcionan abundante información y son sumamente útiles para encontrar [valores atípicos](https://es.wikipedia.org/wiki/Valor_at%C3%ADpico) y comparar dos [conjunto de datos](https://es.wikipedia.org/wiki/Conjunto_de_datos).

#

#

#

# Actualmente con el boom de la [Big Data](http://es.wikipedia.org/wiki/Big_data), tener nociones de *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)* y *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* se ha hecho fundamental. En los últimos años ha habido un resurgimiento de todo lo relacionado con *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* , *[data mining](http://es.wikipedia.org/wiki/Miner%C3%ADa_de_datos)* y *[machine learning](http://es.wikipedia.org/wiki/Aprendizaje_autom%C3%A1tico)* empujados principalmente por la explosión de datos con que contamos, estos conceptos combinados forman la base de lo que actualmente se conoce como la *[Ciencia de Datos](http://en.wikipedia.org/wiki/Data_science)*. Dentro de este contexto, [Python](http://python.org/) es uno de los lenguajes que más nos facilita trabajar con datos. Realizar complejos análisis estadísticos nunca fue tan fácil como con [Python](http://python.org/)!

#

# ## ¿Qué es la Estadística?

#

# La *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* suele ser definida como la ciencia de aprender de los *[datos](https://es.wikipedia.org/wiki/Dato)* o como la ciencia de obtener conclusiones en la presencia de incertidumbre. Se relaciona principalmente con la recolección, análisis e interpretación de *[datos](https://es.wikipedia.org/wiki/Dato)*, así como también con la efectiva comunicación y presentación de los resultados basados en esos *[datos](https://es.wikipedia.org/wiki/Dato)*. Como por *[datos](https://es.wikipedia.org/wiki/Dato)* entendemos a cualquier clase de información grabada, la *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* juego un rol importante en muchas disciplinas científicas.

#

# La *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* puede ser muy importante para una efectiva toma de decisiones. Existe una gran cantidad de valiosa información escondida entre los *[datos](https://es.wikipedia.org/wiki/Dato)*, pero esta información no suele ser fácilmente accesible, la *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* nos brinda los principios fundamentales que nos permiten extraer y entender esa información; tambien nos proporciona las herramientas necesarias para verificar la calidad de nuestros *[datos](https://es.wikipedia.org/wiki/Dato)* y nuestra información.

#

# La *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* suele ser dividida en dos grandes ramas:

#

# 1. La *[estadística descriptiva](https://es.wikipedia.org/wiki/Estad%C3%ADstica_descriptiva)*: La cual se dedica a recolectar, ordenar, analizar y representar a un [conjunto de datos](https://es.wikipedia.org/wiki/Conjunto_de_datos), con el fin de describir apropiadamente las características de este. Calcula los parámetros estadísticos que describen el conjunto estudiado. Algunas de las herramientas que utiliza son gráficos, medidas de frecuencias, medidas de centralización, medidas de posición, medidas de dispersión, entre otras.

#

# 2. La *[estadistica inferencial](https://es.wikipedia.org/wiki/Estad%C3%ADstica_inferencial)*: La cual estudia cómo sacar conclusiones generales para toda la [población](https://es.wikipedia.org/wiki/Poblaci%C3%B3n_estad%C3%ADstica) a partir del estudio de una muestra, y el grado de fiabilidad o significación de los resultados obtenidos. Sus principales herramientas son el muestreo, la estimación de parámetros y el contraste de hipótesis.

# ## ¿Qué es la Probabilidad?

#

# La *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)* mide la mayor o menor posibilidad de que se dé un determinado resultado (suceso o evento) cuando se realiza un experimento aleatorio.

# Para calcular la probabilidad de un evento se toma en cuenta todos los casos posibles de ocurrencia del mismo; es decir, de cuántas formas puede ocurrir determinada situación.Los casos favorables de ocurrencia de un evento serán los que cumplan con la condición que estamos buscando. La *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)* toma valores entre 0 y 1 (o expresados en tanto por ciento, entre 0% y 100%).

#

# La *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)* es a la vez el inverso y complemento para la *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)*. Dónde la *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* nos ayuda a ir desde los *[datos](https://es.wikipedia.org/wiki/Dato)* observados hasta hacer generalizaciones sobre como funcionan las cosas; la *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)* funciona en la dirección inversa: si asumimos que sabemos como las cosas funcionan, entonces podemos averiguar la clase de *[datos](https://es.wikipedia.org/wiki/Dato)* que vamos a ver y cuan probable es que los veamos.

#

# La *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)* también funciona como complemento de la *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* cuando nos proporciona una sólida base para la *[estadistica inferencial](https://es.wikipedia.org/wiki/Estad%C3%ADstica_inferencial)*. Cuando hay incertidumbre, no sabemos que puede pasar y hay alguna posibilidad de errores, utilizando *[probabilidades](https://es.wikipedia.org/wiki/Probabilidad)* podemos aprender formas de controlar la tasa de errores para reducirlos.

# ## Actividades básicas del analisis estadístico

#

# Las técnicas *[estadísticas](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* deberían ser vistas como una parte importante de cualquier proceso de toma de dicisiones, permitiendo tomar decisiones estratégicamente informadas que combinen intuición con experiencia y un entendimiento *[estadístico](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* de los *[datos](https://es.wikipedia.org/wiki/Dato)* que tenemos disponibles.

#

# Un análisis estadístico suele contener 5 actividades básicas:

#

# 1. **Diseño del análisis**: Esta actividad involucra el planeamiento de los detalles para obtener los datos que necesitamos y la generación de la hipótesis a ser evaluada.

#

# 2. **Exploración de datos**: En esta actividad nos dedicamos a jugar con nuestros datos, los describimos, los resumimos, realizamos gráficos para mirarlos desde distintos ángulos. Esta exploración nos ayuda a asegurarnos que los datos que obtuvimos son completos y que la etapa de diseño fue correcta.

#

# 3. **Armado del modelo**: En esta actividad intentamos armar un modelo que explique el comportamiento de nuestros datos y pueda llegar a hacer predicciones sobre los mismos. La idea es que el modelo pueda describir las propiedades fundamentales de nuestros datos.

#

# 4. **Realizar estimaciones**: Aquí vamos a intentar realizar estimaciones basadas en el modelo que armamos anteriormente. También vamos a intentar estimar el tamaño del error que nuestro modelo puede tener en sus predicciones.

#

# 5. **Contraste de la hipótesis**: Esta actividad es la que va a producir la decisión final sobre si las predicciones del modelo son correctas y ayudarnos a concluir si los datos que poseemos confirman o rechazan la hipótesis que generamos en la actividad 1.

# ## Conceptos básicos de la estadística descriptiva

#

# En *[estadística descriptiva](https://es.wikipedia.org/wiki/Estad%C3%ADstica_descriptiva)* se utilizan distintas medidas para intentar describir las propiedades de nuestros datos, algunos de los conceptos básicos, son:

#

# * **Media aritmética**: La [media aritmética](https://es.wikipedia.org/wiki/Media_aritm%C3%A9tica) es el valor obtenido al sumar todos los *[datos](https://es.wikipedia.org/wiki/Dato)* y dividir el resultado entre el número total elementos. Se suele representar con la letra griega $\mu$. Si tenemos una [muestra](https://es.wikipedia.org/wiki/Muestra_estad%C3%ADstica) de $n$ valores, $x_i$, la *media aritmética*, $\mu$, es la suma de los valores divididos por el numero de elementos; en otras palabras:

# $$\mu = \frac{1}{n} \sum_{i}x_i$$

#

#

# * **Desviación respecto a la media**: La desviación respecto a la media es la diferencia en valor absoluto entre cada valor de la variable estadística y la media aritmética.

# $$D_i = |x_i - \mu|$$

#

#

# * **Varianza**: La [varianza](https://es.wikipedia.org/wiki/Varianza) es la media aritmética del cuadrado de las desviaciones respecto a la media de una distribución estadística. La varianza intenta describir la dispersión de los *[datos](https://es.wikipedia.org/wiki/Dato)*. Se representa como $\sigma^2$.

# $$\sigma^2 = \frac{\sum\limits_{i=1}^n(x_i - \mu)^2}{n} $$

#

#

# * **Desviación típica**: La [desviación típica](https://es.wikipedia.org/wiki/Desviaci%C3%B3n_t%C3%ADpica) es la raíz cuadrada de la varianza. Se representa con la letra griega $\sigma$.

# $$\sigma = \sqrt{\frac{\sum\limits_{i=1}^n(x_i - \mu)^2}{n}} $$

#

#

# * **Moda**: La moda es el valor que tiene mayor frecuencia absoluta. Se representa con $M_0$

#

#

# * **Mediana**: La mediana es el valor que ocupa el lugar central de todos los datos cuando éstos están ordenados de menor a mayor. Se representa con $\widetilde{x}$.

#

#

# * **Correlación**: La [correlación](https://es.wikipedia.org/wiki/Correlaci%C3%B3n) trata de establecer la relación o dependencia que existe entre las dos variables que intervienen en una distribución bidimensional. Es decir, determinar si los cambios en una de las variables influyen en los cambios de la otra. En caso de que suceda, diremos que las variables están correlacionadas o que hay correlación entre ellas. La correlación es positiva cuando los valores de las variables aumenta juntos; y es negativa cuando un valor de una variable se reduce cuando el valor de la otra variable aumenta.

#

#

# * **Covarianza**: La [covarianza](https://es.wikipedia.org/wiki/Covarianza) es el equivalente de la varianza aplicado a una variable bidimensional. Es la media aritmética de los productos de las desviaciones de cada una de las variables respecto a sus medias respectivas.La covarianza indica el sentido de la correlación entre las variables; Si $\sigma_{xy} > 0$ la correlación es directa; Si $\sigma_{xy} < 0$ la correlación es inversa.

#

# $$\sigma_{xy} = \frac{\sum\limits_{i=1}^n(x_i - \mu_x)(y_i -\mu_y)}{n}$$

#

#

# * **Valor atípico**: Un [valor atípico](https://es.wikipedia.org/wiki/Valor_at%C3%ADpico) es una observación que se aleja demasiado de la moda; esta muy lejos de la tendencia principal del resto de los *[datos](https://es.wikipedia.org/wiki/Dato)*. Pueden ser causados por errores en la recolección de *[datos](https://es.wikipedia.org/wiki/Dato)* o medidas inusuales. Generalmente se recomienda eliminarlos del [conjunto de datos](https://es.wikipedia.org/wiki/Conjunto_de_datos).

#

# ## Librerías de Python para probabilidad y estadística

#

# Como ya les vengo mostrando en mis anteriores artículos, [Python](http://python.org/) se lleva muy bien con las matemáticas. Además, la [comunidad python](https://www.python.org/community/) es tan amplia que solemos encontrar una librería para cualquier problema al que nos enfrentemos. En este caso, los principales módulos que [Python](http://python.org/) nos ofrece para trabajar con *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)* y *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)*, son:

#

# * **[numpy](http://www.numpy.org/)**: El popular paquete matemático de [Python](http://python.org/), se utiliza tanto que mucha gente ya lo considera parte integral del lenguaje. Nos proporciona algunas funciones estadísticas que podemos aplicar fácilmente sobre los *arrays* de [Numpy](http://www.numpy.org/).

#

# * **[scipy.stats](http://docs.scipy.org/doc/scipy/reference/tutorial/stats.html)**: Este submodulo del paquete científico [Scipy](http://docs.scipy.org/doc/scipy/reference/index.html) es el complemento perfecto para [Numpy](http://www.numpy.org/), las funciones estadisticas que no encontremos en uno, las podemos encontrar en el otro.

#

# * **[statsmodels](http://statsmodels.sourceforge.net/)**: Esta librería nos brinda un gran número de herramientas para explorar *[datos](https://es.wikipedia.org/wiki/Dato)*, estimar modelos estadísticos, realizar pruebas estadísticas y muchas cosas más.

#

# * **[matplotlib](http://matplotlib.org/)**: Es la librería más popular en [Python](http://python.org/) para visualizaciones y gráficos. Ella nos va a permitir realizar los gráficos de las distintas distribuciones de datos.

#

# * **[seaborn](http://stanford.edu/~mwaskom/software/seaborn/)**: Esta librería es un complemento ideal de [matplotlib](http://matplotlib.org/) para realizar gráficos estadísticos.

#

# * **[pandas](http://pandas.pydata.org/)**: Esta es la librería más popular para análisis de *[datos](https://es.wikipedia.org/wiki/Dato)* y financieros. Posee algunas funciones muy útiles para realizar *[estadística descriptiva](https://es.wikipedia.org/wiki/Estad%C3%ADstica_descriptiva)* sobre nuestros datos y nos facilita sobremanera el trabajar con [series de tiempo](https://es.wikipedia.org/wiki/Serie_temporal).

#

# * **[pyMC](http://pymc-devs.github.io/pymc/index.html)**: [pyMC](http://pymc-devs.github.io/pymc/index.html) es un módulo de [Python](http://python.org/) que implementa modelos estadísticos bayesianos, incluyendo la [cadena de Markov Monte Carlo(MCMC)](https://en.wikipedia.org/wiki/Markov_chain_Monte_Carlo). [pyMC](http://pymc-devs.github.io/pymc/index.html) ofrece funcionalidades para hacer el análisis bayesiano lo mas simple posible.

# ### Ejemplos en Python

#

# Calcular los principales indicadores de la *[estadística descriptiva](https://es.wikipedia.org/wiki/Estad%C3%ADstica_descriptiva)* con [Python](http://python.org/) es muy fácil!.

# In[1]:

# Ejemplos de estadistica descriptiva con python

import numpy as np # importando numpy

from scipy import stats # importando scipy.stats

import pandas as pd # importando pandas

np.random.seed(2131982) # para poder replicar el random

# In[2]:

datos = np.random.randn(5, 4) # datos normalmente distribuidos

datos

# In[3]:

# media arítmetica

datos.mean() # Calcula la media aritmetica de

# In[4]:

np.mean(datos) # Mismo resultado desde la funcion de numpy

# In[5]:

datos.mean(axis=1) # media aritmetica de cada fila

# In[6]:

datos.mean(axis=0) # media aritmetica de cada columna

# In[7]:

# mediana

np.median(datos)

# In[8]:

np.median(datos, 0) # media aritmetica de cada columna

# In[9]:

# Desviación típica

np.std(datos)

# In[10]:

np.std(datos, 0) # Desviación típica de cada columna

# In[11]:

# varianza

np.var(datos)

# In[12]:

np.var(datos, 0) # varianza de cada columna

# In[13]:

# moda

stats.mode(datos) # Calcula la moda de cada columna

# el 2do array devuelve la frecuencia.

# In[14]:

datos2 = np.array([1, 2, 3, 6, 6, 1, 2, 4, 2, 2, 6, 6, 8, 10, 6])

stats.mode(datos2) # aqui la moda es el 6 porque aparece 5 veces en el vector.

# In[15]:

# correlacion

np.corrcoef(datos) # Crea matriz de correlación.

# In[16]:

# calculando la correlación entre dos vectores.

np.corrcoef(datos[0], datos[1])

# In[17]:

# covarianza

np.cov(datos) # calcula matriz de covarianza

# In[18]:

# covarianza de dos vectores

np.cov(datos[0], datos[1])

# In[19]:

# usando pandas

dataframe = pd.DataFrame(datos, index=['a', 'b', 'c', 'd', 'e'],

columns=['col1', 'col2', 'col3', 'col4'])

dataframe

# In[20]:

# resumen estadistadistico con pandas

dataframe.describe()

# In[21]:

# sumando las columnas

dataframe.sum()

# In[22]:

# sumando filas

dataframe.sum(axis=1)

# In[23]:

dataframe.cumsum() # acumulados

# In[24]:

# media aritmetica de cada columna con pandas

dataframe.mean()

# In[25]:

# media aritmetica de cada fila con pandas

dataframe.mean(axis=1)

# ## Histogramas y Distribuciones

#

# Muchas veces los indicadores de la *[estadística descriptiva](https://es.wikipedia.org/wiki/Estad%C3%ADstica_descriptiva)* no nos proporcionan una imagen clara de nuestros *[datos](https://es.wikipedia.org/wiki/Dato)*. Por esta razón, siempre es útil complementarlos con gráficos de las distribuciones de los *[datos](https://es.wikipedia.org/wiki/Dato)*, que describan con qué frecuencia aparece cada valor. La representación más común de una distribución es un [histograma](https://es.wikipedia.org/wiki/Histograma), que es un gráfico que muestra la frecuencia o probabilidad de cada valor. El [histograma](https://es.wikipedia.org/wiki/Histograma) muestra las frecuencias como un gráfico de barras que indica cuan frecuente un determinado valor ocurre en el [conjunto de datos](https://es.wikipedia.org/wiki/Conjunto_de_datos). El eje horizontal representa los valores del [conjunto de datos](https://es.wikipedia.org/wiki/Conjunto_de_datos) y el eje vertical representa la frecuencia con que esos valores ocurren.

#

# Las distribuciones se pueden clasificar en dos grandes grupos:

#

# 1. Las **[distribuciones continuas](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_de_probabilidad_continua)**, que son aquellas que presentan un número infinito de posibles soluciones. Dentro de este grupo vamos a encontrar a las distribuciones:

# * [normal](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_normal),

# * [gamma](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_gamma),

# * [chi cuadrado](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_%CF%87%C2%B2),

# * [t de Student](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_t_de_Student),

# * [pareto](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_de_Pareto),

# * entre otras

#

# 2. Las **distribuciones discretas**, que son aquellas en las que la variable puede pude tomar un número determinado de valores. Los principales exponenetes de este grupo son las distribuciones:

# * [poisson](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_de_Poisson),

# * [binomial](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_binomial),

# * [hipergeométrica](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_hipergeom%C3%A9trica),

# * [bernoulli](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_de_Bernoulli)

# * entre otras

#

# Veamos algunos ejemplos graficados con la ayuda de [Python](http://python.org/).

# ### Distribución normal

#

# La [distribución normal](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_normal) es una de las principales distribuciones, ya que es la que con más frecuencia aparece aproximada en los fenómenos reales. Tiene una forma acampanada y es simétrica respecto de un determinado parámetro estadístico. Con la ayuda de [Python](http://python.org/) la podemos graficar de la siguiente manera:

# In[26]:

# Graficos embebidos.

get_ipython().run_line_magic('matplotlib', 'inline')

# In[27]:

import matplotlib.pyplot as plt # importando matplotlib

import seaborn as sns # importando seaborn

# parametros esteticos de seaborn

sns.set_palette("deep", desat=.6)

sns.set_context(rc={"figure.figsize": (8, 4)})

# In[28]:

mu, sigma = 0, 0.1 # media y desvio estandar

s = np.random.normal(mu, sigma, 1000) #creando muestra de datos

# In[29]:

# histograma de distribución normal.

cuenta, cajas, ignorar = plt.hist(s, 30, normed=True)

normal = plt.plot(cajas, 1/(sigma * np.sqrt(2 * np.pi)) *

np.exp( - (cajas - mu)**2 / (2 * sigma**2) ),

linewidth=2, color='r')

# ### Distribuciones simetricas y asimetricas

#

# Una distribución es simétrica cuando moda, mediana y media coinciden aproximadamente en sus valores. Si una distribución es simétrica, existe el mismo número de valores a la derecha que a la izquierda de la media, por tanto, el mismo número de desviaciones con signo positivo que con signo negativo.

#

# Una distribución tiene [asimetria](https://es.wikipedia.org/wiki/Asimetr%C3%ADa_estad%C3%ADstica) positiva (o a la derecha) si la "cola" a la derecha de la media es más larga que la de la izquierda, es decir, si hay valores más separados de la media a la derecha. De la misma forma una distribución tiene [asimetria](https://es.wikipedia.org/wiki/Asimetr%C3%ADa_estad%C3%ADstica) negativa (o a la izquierda) si la "cola" a la izquierda de la media es más larga que la de la derecha, es decir, si hay valores más separados de la media a la izquierda.

#

# Las distribuciones asimétricas suelen ser problemáticas, ya que la mayoría de los métodos estadísticos suelen estar desarrollados para distribuciones del tipo [normal](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_normal). Para salvar estos problemas se suelen realizar transformaciones a los datos para hacer a estas distribuciones más simétricas y acercarse a la [distribución normal](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_normal).

# In[30]:

# Dibujando la distribucion Gamma

x = stats.gamma(3).rvs(5000)

gamma = plt.hist(x, 70, histtype="stepfilled", alpha=.7)

# En este ejemplo podemos ver que la [distribución gamma](https://es.wikipedia.org/wiki/Distribuci%C3%B3n_gamma) que dibujamos tiene una [asimetria](https://es.wikipedia.org/wiki/Asimetr%C3%ADa_estad%C3%ADstica) positiva.

# In[31]:

# Calculando la simetria con scipy

stats.skew(x)

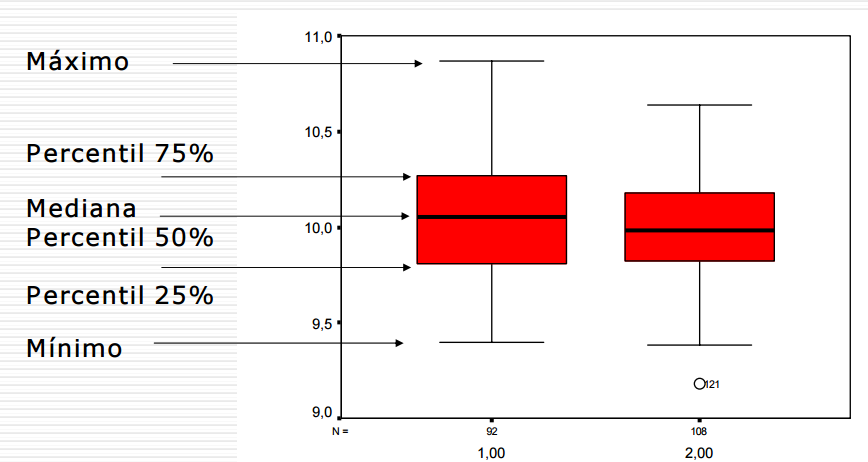

# ## Cuartiles y diagramas de cajas

#

# Los **[cuartiles](https://es.wikipedia.org/wiki/Cuartil)** son los tres valores de la variable estadística que dividen a un [conjunto de datos](https://es.wikipedia.org/wiki/Conjunto_de_datos) ordenados en cuatro partes iguales. Q1, Q2 y Q3 determinan los valores correspondientes al 25%, al 50% y al 75% de los datos. Q2 coincide con la mediana.

#

# Los [diagramas de cajas](https://es.wikipedia.org/wiki/Diagrama_de_caja) son una presentación visual que describe varias características importantes al mismo tiempo, tales como la dispersión y simetría. Para su realización se representan los tres cuartiles y los valores mínimo y máximo de los datos, sobre un rectángulo, alineado horizontal o verticalmente. Estos gráficos nos proporcionan abundante información y son sumamente útiles para encontrar [valores atípicos](https://es.wikipedia.org/wiki/Valor_at%C3%ADpico) y comparar dos [conjunto de datos](https://es.wikipedia.org/wiki/Conjunto_de_datos).

#

#

#  # In[32]:

# Ejemplo de grafico de cajas en python

datos_1 = np.random.normal(100, 10, 200)

datos_2 = np.random.normal(80, 30, 200)

datos_3 = np.random.normal(90, 20, 200)

datos_4 = np.random.normal(70, 25, 200)

datos_graf = [datos_1, datos_2, datos_3, datos_4]

# Creando el objeto figura

fig = plt.figure(1, figsize=(9, 6))

# Creando el subgrafico

ax = fig.add_subplot(111)

# creando el grafico de cajas

bp = ax.boxplot(datos_graf)

# visualizar mas facile los atípicos

for flier in bp['fliers']:

flier.set(marker='o', color='red', alpha=0.5)

# los puntos aislados son valores atípicos

# In[33]:

# usando seaborn

sns.boxplot(datos_graf, names=["grupo1", "grupo2", "grupo3", "grupo 4"],

color="PaleGreen");

# ## Regresiones

#

# Las **regresiones** es una de las herramientas principales de la *[estadistica inferencial](https://es.wikipedia.org/wiki/Estad%C3%ADstica_inferencial)*. El objetivo del [análisis de regresión](https://es.wikipedia.org/w/index.php?title=An%C3%A1lisis_de_la_regresi%C3%B3n&redirect=no) es describir la relación entre un conjunto de variables, llamadas variables dependientes, y otro conjunto de variables, llamadas variables independientes o explicativas. Más específicamente, el [análisis de regresión](https://es.wikipedia.org/w/index.php?title=An%C3%A1lisis_de_la_regresi%C3%B3n&redirect=no) ayuda a entender cómo el valor típico de la variable dependiente cambia cuando cualquiera de las variables independientes es cambiada, mientras que se mantienen las otras variables independientes fijas. El producto final del [análisis de regresión](https://es.wikipedia.org/w/index.php?title=An%C3%A1lisis_de_la_regresi%C3%B3n&redirect=no) es la estimación de una función de las variables independientes llamada la **función de regresión**. La idea es que en base a esta función de regresión podamos hacer estimaciones sobre eventos futuros.

#

# La [regresión lineal](https://es.wikipedia.org/wiki/Regresi%C3%B3n_lineal) es una de las técnicas más simples y mayormente utilizadas en los [análisis de regresiones](https://es.wikipedia.org/w/index.php?title=An%C3%A1lisis_de_la_regresi%C3%B3n&redirect=no). Hace suposiciones muy rígidas sobre la relación entre la [variable dependiente](https://es.wikipedia.org/wiki/Variable_estad%C3%ADstica#Seg.C3.BAn_la_influencia) $y$ y [variable independiente](https://es.wikipedia.org/wiki/Variable_estad%C3%ADstica#Seg.C3.BAn_la_influencia) $x$. Asume que la relación va a tomar la forma:

#

# $$ y = \beta_0 + \beta_1 * x$$

#

# Uno de los métodos más populares para realizar [regresiones lineales](https://es.wikipedia.org/wiki/Regresi%C3%B3n_lineal) es el de [mínimos cuadrados ordinarios](https://es.wikipedia.org/wiki/M%C3%ADnimos_cuadrados_ordinarios) (OLS, por sus siglas en inglés), este método es el estimador más simple y común en la que los dos $\beta$s se eligen para minimizar el cuadrado de la distancia entre los valores estimados y los valores reales.

#

# Realizar [análisis de regresiones](https://es.wikipedia.org/w/index.php?title=An%C3%A1lisis_de_la_regresi%C3%B3n&redirect=no) en [Python](http://python.org/) es sumamente fácil gracias a [statsmodels](http://statsmodels.sourceforge.net/).

#

# Veamos un pequeño ejemplo utilizando el dataset [longley](http://stat.ethz.ch/R-manual/R-patched/library/datasets/html/longley.html), el cual es ideal para realizar regresiones:

# In[34]:

# importanto la api de statsmodels

import statsmodels.formula.api as smf

import statsmodels.api as sm

# Creando un DataFrame de pandas.

df = pd.read_csv('http://vincentarelbundock.github.io/Rdatasets/csv/datasets/longley.csv', index_col=0)

df.head() # longley dataset

# In[35]:

# utilizando la api de formula de statsmodels

est = smf.ols(formula='Employed ~ GNP', data=df).fit()

est.summary() # Employed se estima en base a GNP.

# Como podemos ver, el resumen que nos brinda [statsmodels](http://statsmodels.sourceforge.net/) sobre nuestro modelo de [regresión](https://es.wikipedia.org/wiki/Regresi%C3%B3n_lineal) contiene bastante información sobre como se ajuste el modelo a los datos. Pasemos a explicar algunos de estos valores:

#

# * **Dep. Variable:** es la variable que estamos estimasdo.

# * **Model:** es el modelo que estamos utilizando.

# * **R-squared:** es el [coeficiente de determinación](https://es.wikipedia.org/wiki/Coeficiente_de_determinaci%C3%B3n), el cual mide cuan bien nuestra recta de regresion se aproxima a los datos reales.

# * **Adj. R-squared:** es el coeficiente anterior ajustado según el número de observaciones.

# * **[95.0% Conf. Int.]:** Los valores inferior y superior del intervalo de confianza del 95%.

# * **coef:** el valor estimado del coeficiente.

# * **std err:** el error estándar de la estimación del coeficiente.

# * **Skew:** una medida de la [asimetria](https://es.wikipedia.org/wiki/Asimetr%C3%ADa_estad%C3%ADstica) de los datos sobre la media.

# * **Kurtosis:** Una medida de la forma de la distribución. La [curtosis](https://es.wikipedia.org/wiki/Curtosis) compara la cantidad de datos cerca de la media con los que están más lejos de la media(en las colas).

# In[36]:

# grafico de regresion. que tanto se ajusta el modelo a los datos.

y = df.Employed # Respuesta

X = df.GNP # Predictor

X = sm.add_constant(X) # agrega constante

X_1 = pd.DataFrame({'GNP': np.linspace(X.GNP.min(), X.GNP.max(), 100)})

X_1 = sm.add_constant(X_1)

y_reg = est.predict(X_1) # estimacion

plt.scatter(X.GNP, y, alpha=0.3) # grafica los puntos de datos

plt.ylim(30, 100) # limite de eje y

plt.xlabel("Producto bruto") # leyenda eje x

plt.ylabel("Empleo") # leyenda eje y

plt.title("Ajuste de regresion") # titulo del grafico

reg = plt.plot(X_1.GNP, y_reg, 'r', alpha=0.9) # linea de regresion

# In[37]:

# grafico de influencia

from statsmodels.graphics.regressionplots import influence_plot

inf =influence_plot(est)

# Este último gráfico nos muestra el apalancamiento y la influencia de cada caso.

# ## La estadística bayesiana

#

# La *[estadística bayesiana](https://es.wikipedia.org/wiki/Estad%C3%ADstica_bayesiana)* es un subconjunto del campo de la *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* en la que la evidencia sobre el verdadero estado de las cosas se expresa en términos de grados de creencia. Esta filosofía de tratar a las creencias como probabilidad es algo natural para los seres humanos. Nosotros la utilizamos constantemente a medida que interactuamos con el mundo y sólo vemos verdades parciales; necesitando reunir pruebas para formar nuestras creencias.

#

# La diferencia fundamental entre la *[estadística clásica](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* (frecuentista) y la *[bayesiana](https://es.wikipedia.org/wiki/Estad%C3%ADstica_bayesiana)* es el concepto de

# *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)*. Para la *[estadística clásica](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* es un concepto objetivo, que se encuentra en la naturaleza,

# mientras que para la *[estadística bayesiana](https://es.wikipedia.org/wiki/Estad%C3%ADstica_bayesiana)* se encuentra en el observador, siendo así un concepto subjetivo. De este modo, en *[estadística clásica](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* solo se toma como fuente de información las muestras

# obtenidas. En el caso *[bayesiano](https://es.wikipedia.org/wiki/Estad%C3%ADstica_bayesiana)*, sin embargo, además de la muestra también juega un papel fundamental la información previa o externa que se posee en relación a los fenómenos que se tratan de modelar.

#

# La *[estadística bayesiana](https://es.wikipedia.org/wiki/Estad%C3%ADstica_bayesiana)* está demostrando su utilidad en ciertas estimaciones basadas en el conocimiento subjetivo a priori y el hecho de permitir revisar esas estimaciones en función de la evidencia empírica es lo que está abriendo nuevas formas de hacer conocimiento. Una aplicación de esto son los [clasificadores bayesianos](https://es.wikipedia.org/wiki/Clasificador_bayesiano_ingenuo) que son frecuentemente usados en implementaciones de filtros de correo basura, que se adaptan con el uso. La *[estadística bayesiana](https://es.wikipedia.org/wiki/Estad%C3%ADstica_bayesiana)* es un tema muy interesante que merece un artículo en sí mismo.

#

# Para entender más fácilmente como funciona la *[estadística bayesiana](https://es.wikipedia.org/wiki/Estad%C3%ADstica_bayesiana)* veamos un simple ejemplo del lanzamiento de una moneda. La idea principal de la inferencia bayesiana es que la noción de *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)* cambia mientras más *[datos](https://es.wikipedia.org/wiki/Dato)* tengamos.

# In[38]:

sns.set_context(rc={"figure.figsize": (11, 9)})

dist = stats.beta

n_trials = [0, 1, 2, 3, 4, 5, 8, 15, 50, 500]

data = stats.bernoulli.rvs(0.5, size=n_trials[-1])

x = np.linspace(0, 1, 100)

for k, N in enumerate(n_trials):

sx = plt.subplot(len(n_trials) / 2, 2, k + 1)

plt.xlabel("$p$, probabilidad de cara") \

if k in [0, len(n_trials) - 1] else None

plt.setp(sx.get_yticklabels(), visible=False)

heads = data[:N].sum()

y = dist.pdf(x, 1 + heads, 1 + N - heads)

plt.plot(x, y, label="lanzamientos observados %d,\n %d caras" % (N, heads))

plt.fill_between(x, 0, y, color="#348ABD", alpha=0.4)

plt.vlines(0.5, 0, 4, color="k", linestyles="--", lw=1)

leg = plt.legend()

leg.get_frame().set_alpha(0.4)

plt.autoscale(tight=True)

plt.suptitle("Actualizacion Bayesiana de probabilidades posterios",

y=1.02,

fontsize=14)

plt.tight_layout()

# Como el gráfico de arriba muestra, cuando empezamos a observar nuevos *[datos](https://es.wikipedia.org/wiki/Dato)* nuestras probabilidades posteriores comienzan a cambiar y moverse. Eventualmente, a medida que observamos más y más datos (lanzamientos de monedas), nuestras probabilidades se acercan más y más hacia el verdadero valor de p = 0.5 (marcado por una línea discontinua).

# Aquí termina este tutorial, espero que les haya sido util.

#

# Saludos!

#

# *Este post fue escrito utilizando IPython notebook. Pueden descargar este [notebook](https://github.com/relopezbriega/relopezbriega.github.io/blob/master/downloads/pythonStats.ipynb) o ver su version estática en [nbviewer](http://nbviewer.ipython.org/github/relopezbriega/relopezbriega.github.io/blob/master/downloads/pythonStats.ipynb).*

# In[32]:

# Ejemplo de grafico de cajas en python

datos_1 = np.random.normal(100, 10, 200)

datos_2 = np.random.normal(80, 30, 200)

datos_3 = np.random.normal(90, 20, 200)

datos_4 = np.random.normal(70, 25, 200)

datos_graf = [datos_1, datos_2, datos_3, datos_4]

# Creando el objeto figura

fig = plt.figure(1, figsize=(9, 6))

# Creando el subgrafico

ax = fig.add_subplot(111)

# creando el grafico de cajas

bp = ax.boxplot(datos_graf)

# visualizar mas facile los atípicos

for flier in bp['fliers']:

flier.set(marker='o', color='red', alpha=0.5)

# los puntos aislados son valores atípicos

# In[33]:

# usando seaborn

sns.boxplot(datos_graf, names=["grupo1", "grupo2", "grupo3", "grupo 4"],

color="PaleGreen");

# ## Regresiones

#

# Las **regresiones** es una de las herramientas principales de la *[estadistica inferencial](https://es.wikipedia.org/wiki/Estad%C3%ADstica_inferencial)*. El objetivo del [análisis de regresión](https://es.wikipedia.org/w/index.php?title=An%C3%A1lisis_de_la_regresi%C3%B3n&redirect=no) es describir la relación entre un conjunto de variables, llamadas variables dependientes, y otro conjunto de variables, llamadas variables independientes o explicativas. Más específicamente, el [análisis de regresión](https://es.wikipedia.org/w/index.php?title=An%C3%A1lisis_de_la_regresi%C3%B3n&redirect=no) ayuda a entender cómo el valor típico de la variable dependiente cambia cuando cualquiera de las variables independientes es cambiada, mientras que se mantienen las otras variables independientes fijas. El producto final del [análisis de regresión](https://es.wikipedia.org/w/index.php?title=An%C3%A1lisis_de_la_regresi%C3%B3n&redirect=no) es la estimación de una función de las variables independientes llamada la **función de regresión**. La idea es que en base a esta función de regresión podamos hacer estimaciones sobre eventos futuros.

#

# La [regresión lineal](https://es.wikipedia.org/wiki/Regresi%C3%B3n_lineal) es una de las técnicas más simples y mayormente utilizadas en los [análisis de regresiones](https://es.wikipedia.org/w/index.php?title=An%C3%A1lisis_de_la_regresi%C3%B3n&redirect=no). Hace suposiciones muy rígidas sobre la relación entre la [variable dependiente](https://es.wikipedia.org/wiki/Variable_estad%C3%ADstica#Seg.C3.BAn_la_influencia) $y$ y [variable independiente](https://es.wikipedia.org/wiki/Variable_estad%C3%ADstica#Seg.C3.BAn_la_influencia) $x$. Asume que la relación va a tomar la forma:

#

# $$ y = \beta_0 + \beta_1 * x$$

#

# Uno de los métodos más populares para realizar [regresiones lineales](https://es.wikipedia.org/wiki/Regresi%C3%B3n_lineal) es el de [mínimos cuadrados ordinarios](https://es.wikipedia.org/wiki/M%C3%ADnimos_cuadrados_ordinarios) (OLS, por sus siglas en inglés), este método es el estimador más simple y común en la que los dos $\beta$s se eligen para minimizar el cuadrado de la distancia entre los valores estimados y los valores reales.

#

# Realizar [análisis de regresiones](https://es.wikipedia.org/w/index.php?title=An%C3%A1lisis_de_la_regresi%C3%B3n&redirect=no) en [Python](http://python.org/) es sumamente fácil gracias a [statsmodels](http://statsmodels.sourceforge.net/).

#

# Veamos un pequeño ejemplo utilizando el dataset [longley](http://stat.ethz.ch/R-manual/R-patched/library/datasets/html/longley.html), el cual es ideal para realizar regresiones:

# In[34]:

# importanto la api de statsmodels

import statsmodels.formula.api as smf

import statsmodels.api as sm

# Creando un DataFrame de pandas.

df = pd.read_csv('http://vincentarelbundock.github.io/Rdatasets/csv/datasets/longley.csv', index_col=0)

df.head() # longley dataset

# In[35]:

# utilizando la api de formula de statsmodels

est = smf.ols(formula='Employed ~ GNP', data=df).fit()

est.summary() # Employed se estima en base a GNP.

# Como podemos ver, el resumen que nos brinda [statsmodels](http://statsmodels.sourceforge.net/) sobre nuestro modelo de [regresión](https://es.wikipedia.org/wiki/Regresi%C3%B3n_lineal) contiene bastante información sobre como se ajuste el modelo a los datos. Pasemos a explicar algunos de estos valores:

#

# * **Dep. Variable:** es la variable que estamos estimasdo.

# * **Model:** es el modelo que estamos utilizando.

# * **R-squared:** es el [coeficiente de determinación](https://es.wikipedia.org/wiki/Coeficiente_de_determinaci%C3%B3n), el cual mide cuan bien nuestra recta de regresion se aproxima a los datos reales.

# * **Adj. R-squared:** es el coeficiente anterior ajustado según el número de observaciones.

# * **[95.0% Conf. Int.]:** Los valores inferior y superior del intervalo de confianza del 95%.

# * **coef:** el valor estimado del coeficiente.

# * **std err:** el error estándar de la estimación del coeficiente.

# * **Skew:** una medida de la [asimetria](https://es.wikipedia.org/wiki/Asimetr%C3%ADa_estad%C3%ADstica) de los datos sobre la media.

# * **Kurtosis:** Una medida de la forma de la distribución. La [curtosis](https://es.wikipedia.org/wiki/Curtosis) compara la cantidad de datos cerca de la media con los que están más lejos de la media(en las colas).

# In[36]:

# grafico de regresion. que tanto se ajusta el modelo a los datos.

y = df.Employed # Respuesta

X = df.GNP # Predictor

X = sm.add_constant(X) # agrega constante

X_1 = pd.DataFrame({'GNP': np.linspace(X.GNP.min(), X.GNP.max(), 100)})

X_1 = sm.add_constant(X_1)

y_reg = est.predict(X_1) # estimacion

plt.scatter(X.GNP, y, alpha=0.3) # grafica los puntos de datos

plt.ylim(30, 100) # limite de eje y

plt.xlabel("Producto bruto") # leyenda eje x

plt.ylabel("Empleo") # leyenda eje y

plt.title("Ajuste de regresion") # titulo del grafico

reg = plt.plot(X_1.GNP, y_reg, 'r', alpha=0.9) # linea de regresion

# In[37]:

# grafico de influencia

from statsmodels.graphics.regressionplots import influence_plot

inf =influence_plot(est)

# Este último gráfico nos muestra el apalancamiento y la influencia de cada caso.

# ## La estadística bayesiana

#

# La *[estadística bayesiana](https://es.wikipedia.org/wiki/Estad%C3%ADstica_bayesiana)* es un subconjunto del campo de la *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* en la que la evidencia sobre el verdadero estado de las cosas se expresa en términos de grados de creencia. Esta filosofía de tratar a las creencias como probabilidad es algo natural para los seres humanos. Nosotros la utilizamos constantemente a medida que interactuamos con el mundo y sólo vemos verdades parciales; necesitando reunir pruebas para formar nuestras creencias.

#

# La diferencia fundamental entre la *[estadística clásica](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* (frecuentista) y la *[bayesiana](https://es.wikipedia.org/wiki/Estad%C3%ADstica_bayesiana)* es el concepto de

# *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)*. Para la *[estadística clásica](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* es un concepto objetivo, que se encuentra en la naturaleza,

# mientras que para la *[estadística bayesiana](https://es.wikipedia.org/wiki/Estad%C3%ADstica_bayesiana)* se encuentra en el observador, siendo así un concepto subjetivo. De este modo, en *[estadística clásica](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* solo se toma como fuente de información las muestras

# obtenidas. En el caso *[bayesiano](https://es.wikipedia.org/wiki/Estad%C3%ADstica_bayesiana)*, sin embargo, además de la muestra también juega un papel fundamental la información previa o externa que se posee en relación a los fenómenos que se tratan de modelar.

#

# La *[estadística bayesiana](https://es.wikipedia.org/wiki/Estad%C3%ADstica_bayesiana)* está demostrando su utilidad en ciertas estimaciones basadas en el conocimiento subjetivo a priori y el hecho de permitir revisar esas estimaciones en función de la evidencia empírica es lo que está abriendo nuevas formas de hacer conocimiento. Una aplicación de esto son los [clasificadores bayesianos](https://es.wikipedia.org/wiki/Clasificador_bayesiano_ingenuo) que son frecuentemente usados en implementaciones de filtros de correo basura, que se adaptan con el uso. La *[estadística bayesiana](https://es.wikipedia.org/wiki/Estad%C3%ADstica_bayesiana)* es un tema muy interesante que merece un artículo en sí mismo.

#

# Para entender más fácilmente como funciona la *[estadística bayesiana](https://es.wikipedia.org/wiki/Estad%C3%ADstica_bayesiana)* veamos un simple ejemplo del lanzamiento de una moneda. La idea principal de la inferencia bayesiana es que la noción de *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)* cambia mientras más *[datos](https://es.wikipedia.org/wiki/Dato)* tengamos.

# In[38]:

sns.set_context(rc={"figure.figsize": (11, 9)})

dist = stats.beta

n_trials = [0, 1, 2, 3, 4, 5, 8, 15, 50, 500]

data = stats.bernoulli.rvs(0.5, size=n_trials[-1])

x = np.linspace(0, 1, 100)

for k, N in enumerate(n_trials):

sx = plt.subplot(len(n_trials) / 2, 2, k + 1)

plt.xlabel("$p$, probabilidad de cara") \

if k in [0, len(n_trials) - 1] else None

plt.setp(sx.get_yticklabels(), visible=False)

heads = data[:N].sum()

y = dist.pdf(x, 1 + heads, 1 + N - heads)

plt.plot(x, y, label="lanzamientos observados %d,\n %d caras" % (N, heads))

plt.fill_between(x, 0, y, color="#348ABD", alpha=0.4)

plt.vlines(0.5, 0, 4, color="k", linestyles="--", lw=1)

leg = plt.legend()

leg.get_frame().set_alpha(0.4)

plt.autoscale(tight=True)

plt.suptitle("Actualizacion Bayesiana de probabilidades posterios",

y=1.02,

fontsize=14)

plt.tight_layout()

# Como el gráfico de arriba muestra, cuando empezamos a observar nuevos *[datos](https://es.wikipedia.org/wiki/Dato)* nuestras probabilidades posteriores comienzan a cambiar y moverse. Eventualmente, a medida que observamos más y más datos (lanzamientos de monedas), nuestras probabilidades se acercan más y más hacia el verdadero valor de p = 0.5 (marcado por una línea discontinua).

# Aquí termina este tutorial, espero que les haya sido util.

#

# Saludos!

#

# *Este post fue escrito utilizando IPython notebook. Pueden descargar este [notebook](https://github.com/relopezbriega/relopezbriega.github.io/blob/master/downloads/pythonStats.ipynb) o ver su version estática en [nbviewer](http://nbviewer.ipython.org/github/relopezbriega/relopezbriega.github.io/blob/master/downloads/pythonStats.ipynb).*

# Actualmente con el boom de la [Big Data](http://es.wikipedia.org/wiki/Big_data), tener nociones de *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)* y *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* se ha hecho fundamental. En los últimos años ha habido un resurgimiento de todo lo relacionado con *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* , *[data mining](http://es.wikipedia.org/wiki/Miner%C3%ADa_de_datos)* y *[machine learning](http://es.wikipedia.org/wiki/Aprendizaje_autom%C3%A1tico)* empujados principalmente por la explosión de datos con que contamos, estos conceptos combinados forman la base de lo que actualmente se conoce como la *[Ciencia de Datos](http://en.wikipedia.org/wiki/Data_science)*. Dentro de este contexto, [Python](http://python.org/) es uno de los lenguajes que más nos facilita trabajar con datos. Realizar complejos análisis estadísticos nunca fue tan fácil como con [Python](http://python.org/)!

#

# ## ¿Qué es la Estadística?

#

# La *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* suele ser definida como la ciencia de aprender de los *[datos](https://es.wikipedia.org/wiki/Dato)* o como la ciencia de obtener conclusiones en la presencia de incertidumbre. Se relaciona principalmente con la recolección, análisis e interpretación de *[datos](https://es.wikipedia.org/wiki/Dato)*, así como también con la efectiva comunicación y presentación de los resultados basados en esos *[datos](https://es.wikipedia.org/wiki/Dato)*. Como por *[datos](https://es.wikipedia.org/wiki/Dato)* entendemos a cualquier clase de información grabada, la *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* juego un rol importante en muchas disciplinas científicas.

#

# La *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* puede ser muy importante para una efectiva toma de decisiones. Existe una gran cantidad de valiosa información escondida entre los *[datos](https://es.wikipedia.org/wiki/Dato)*, pero esta información no suele ser fácilmente accesible, la *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* nos brinda los principios fundamentales que nos permiten extraer y entender esa información; tambien nos proporciona las herramientas necesarias para verificar la calidad de nuestros *[datos](https://es.wikipedia.org/wiki/Dato)* y nuestra información.

#

# La *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* suele ser dividida en dos grandes ramas:

#

# 1. La *[estadística descriptiva](https://es.wikipedia.org/wiki/Estad%C3%ADstica_descriptiva)*: La cual se dedica a recolectar, ordenar, analizar y representar a un [conjunto de datos](https://es.wikipedia.org/wiki/Conjunto_de_datos), con el fin de describir apropiadamente las características de este. Calcula los parámetros estadísticos que describen el conjunto estudiado. Algunas de las herramientas que utiliza son gráficos, medidas de frecuencias, medidas de centralización, medidas de posición, medidas de dispersión, entre otras.

#

# 2. La *[estadistica inferencial](https://es.wikipedia.org/wiki/Estad%C3%ADstica_inferencial)*: La cual estudia cómo sacar conclusiones generales para toda la [población](https://es.wikipedia.org/wiki/Poblaci%C3%B3n_estad%C3%ADstica) a partir del estudio de una muestra, y el grado de fiabilidad o significación de los resultados obtenidos. Sus principales herramientas son el muestreo, la estimación de parámetros y el contraste de hipótesis.

# ## ¿Qué es la Probabilidad?

#

# La *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)* mide la mayor o menor posibilidad de que se dé un determinado resultado (suceso o evento) cuando se realiza un experimento aleatorio.

# Para calcular la probabilidad de un evento se toma en cuenta todos los casos posibles de ocurrencia del mismo; es decir, de cuántas formas puede ocurrir determinada situación.Los casos favorables de ocurrencia de un evento serán los que cumplan con la condición que estamos buscando. La *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)* toma valores entre 0 y 1 (o expresados en tanto por ciento, entre 0% y 100%).

#

# La *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)* es a la vez el inverso y complemento para la *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)*. Dónde la *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* nos ayuda a ir desde los *[datos](https://es.wikipedia.org/wiki/Dato)* observados hasta hacer generalizaciones sobre como funcionan las cosas; la *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)* funciona en la dirección inversa: si asumimos que sabemos como las cosas funcionan, entonces podemos averiguar la clase de *[datos](https://es.wikipedia.org/wiki/Dato)* que vamos a ver y cuan probable es que los veamos.

#

# La *[probabilidad](https://es.wikipedia.org/wiki/Probabilidad)* también funciona como complemento de la *[estadística](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* cuando nos proporciona una sólida base para la *[estadistica inferencial](https://es.wikipedia.org/wiki/Estad%C3%ADstica_inferencial)*. Cuando hay incertidumbre, no sabemos que puede pasar y hay alguna posibilidad de errores, utilizando *[probabilidades](https://es.wikipedia.org/wiki/Probabilidad)* podemos aprender formas de controlar la tasa de errores para reducirlos.

# ## Actividades básicas del analisis estadístico

#

# Las técnicas *[estadísticas](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* deberían ser vistas como una parte importante de cualquier proceso de toma de dicisiones, permitiendo tomar decisiones estratégicamente informadas que combinen intuición con experiencia y un entendimiento *[estadístico](http://es.wikipedia.org/wiki/Estad%C3%ADstica)* de los *[datos](https://es.wikipedia.org/wiki/Dato)* que tenemos disponibles.

#

# Un análisis estadístico suele contener 5 actividades básicas:

#

# 1. **Diseño del análisis**: Esta actividad involucra el planeamiento de los detalles para obtener los datos que necesitamos y la generación de la hipótesis a ser evaluada.

#

# 2. **Exploración de datos**: En esta actividad nos dedicamos a jugar con nuestros datos, los describimos, los resumimos, realizamos gráficos para mirarlos desde distintos ángulos. Esta exploración nos ayuda a asegurarnos que los datos que obtuvimos son completos y que la etapa de diseño fue correcta.

#

# 3. **Armado del modelo**: En esta actividad intentamos armar un modelo que explique el comportamiento de nuestros datos y pueda llegar a hacer predicciones sobre los mismos. La idea es que el modelo pueda describir las propiedades fundamentales de nuestros datos.

#

# 4. **Realizar estimaciones**: Aquí vamos a intentar realizar estimaciones basadas en el modelo que armamos anteriormente. También vamos a intentar estimar el tamaño del error que nuestro modelo puede tener en sus predicciones.

#

# 5. **Contraste de la hipótesis**: Esta actividad es la que va a producir la decisión final sobre si las predicciones del modelo son correctas y ayudarnos a concluir si los datos que poseemos confirman o rechazan la hipótesis que generamos en la actividad 1.

# ## Conceptos básicos de la estadística descriptiva

#

# En *[estadística descriptiva](https://es.wikipedia.org/wiki/Estad%C3%ADstica_descriptiva)* se utilizan distintas medidas para intentar describir las propiedades de nuestros datos, algunos de los conceptos básicos, son:

#

# * **Media aritmética**: La [media aritmética](https://es.wikipedia.org/wiki/Media_aritm%C3%A9tica) es el valor obtenido al sumar todos los *[datos](https://es.wikipedia.org/wiki/Dato)* y dividir el resultado entre el número total elementos. Se suele representar con la letra griega $\mu$. Si tenemos una [muestra](https://es.wikipedia.org/wiki/Muestra_estad%C3%ADstica) de $n$ valores, $x_i$, la *media aritmética*, $\mu$, es la suma de los valores divididos por el numero de elementos; en otras palabras:

# $$\mu = \frac{1}{n} \sum_{i}x_i$$

#

#

# * **Desviación respecto a la media**: La desviación respecto a la media es la diferencia en valor absoluto entre cada valor de la variable estadística y la media aritmética.

# $$D_i = |x_i - \mu|$$

#

#

# * **Varianza**: La [varianza](https://es.wikipedia.org/wiki/Varianza) es la media aritmética del cuadrado de las desviaciones respecto a la media de una distribución estadística. La varianza intenta describir la dispersión de los *[datos](https://es.wikipedia.org/wiki/Dato)*. Se representa como $\sigma^2$.

# $$\sigma^2 = \frac{\sum\limits_{i=1}^n(x_i - \mu)^2}{n} $$

#

#

# * **Desviación típica**: La [desviación típica](https://es.wikipedia.org/wiki/Desviaci%C3%B3n_t%C3%ADpica) es la raíz cuadrada de la varianza. Se representa con la letra griega $\sigma$.

# $$\sigma = \sqrt{\frac{\sum\limits_{i=1}^n(x_i - \mu)^2}{n}} $$

#

#

# * **Moda**: La moda es el valor que tiene mayor frecuencia absoluta. Se representa con $M_0$

#

#

# * **Mediana**: La mediana es el valor que ocupa el lugar central de todos los datos cuando éstos están ordenados de menor a mayor. Se representa con $\widetilde{x}$.

#

#

# * **Correlación**: La [correlación](https://es.wikipedia.org/wiki/Correlaci%C3%B3n) trata de establecer la relación o dependencia que existe entre las dos variables que intervienen en una distribución bidimensional. Es decir, determinar si los cambios en una de las variables influyen en los cambios de la otra. En caso de que suceda, diremos que las variables están correlacionadas o que hay correlación entre ellas. La correlación es positiva cuando los valores de las variables aumenta juntos; y es negativa cuando un valor de una variable se reduce cuando el valor de la otra variable aumenta.

#

#

# * **Covarianza**: La [covarianza](https://es.wikipedia.org/wiki/Covarianza) es el equivalente de la varianza aplicado a una variable bidimensional. Es la media aritmética de los productos de las desviaciones de cada una de las variables respecto a sus medias respectivas.La covarianza indica el sentido de la correlación entre las variables; Si $\sigma_{xy} > 0$ la correlación es directa; Si $\sigma_{xy} < 0$ la correlación es inversa.

#

# $$\sigma_{xy} = \frac{\sum\limits_{i=1}^n(x_i - \mu_x)(y_i -\mu_y)}{n}$$

#

#

# * **Valor atípico**: Un [valor atípico](https://es.wikipedia.org/wiki/Valor_at%C3%ADpico) es una observación que se aleja demasiado de la moda; esta muy lejos de la tendencia principal del resto de los *[datos](https://es.wikipedia.org/wiki/Dato)*. Pueden ser causados por errores en la recolección de *[datos](https://es.wikipedia.org/wiki/Dato)* o medidas inusuales. Generalmente se recomienda eliminarlos del [conjunto de datos](https://es.wikipedia.org/wiki/Conjunto_de_datos).

#

# ## Librerías de Python para probabilidad y estadística

#